GPU hiệu suất cao NVIDIA Hopper H100 được sản xuất chính thức

Các nhà sản xuất máy tính hàng đầu thế giới như Dell Technologies, HPE, Lenovo, Supermicro, Plus Cloud Service Provider AWS, Google Cloud, Microsoft Azure, Oracle Cloud Infrastructure đang cho sản xuất chính thức các hệ thống dựa trên GPU H100 của NVIDIA; Khả năng cung cấp ra thị trường bắt đầu vào tháng 10 tới.

NVIDIA vừa thông báo tại GTC 2022 rằng GPU NVIDIA H100 Tensor Core đang được sản xuất đầy đủ, với các đối tác công nghệ toàn cầu lên kế hoạch cho tháng 10 sẽ tung ra đợt sản phẩm và dịch vụ đầu tiên dựa trên kiến trúc NVIDIA Hopper đột phá.

Công bố vào tháng 4, H100 được chế tạo với 80 tỷ bóng bán dẫn và được hưởng lợi từ một loạt các đột phá công nghệ. Trong số đó có Transformer Engine mới mạnh mẽ và kết nối NVIDIA NVLink để tăng tốc các mô hình AI lớn nhất, như các hệ thống khuyến nghị nâng cao và các mô hình ngôn ngữ lớn, đồng thời thúc đẩy các đổi mới trong các lĩnh vực như AI đàm thoại và khám phá thuốc.

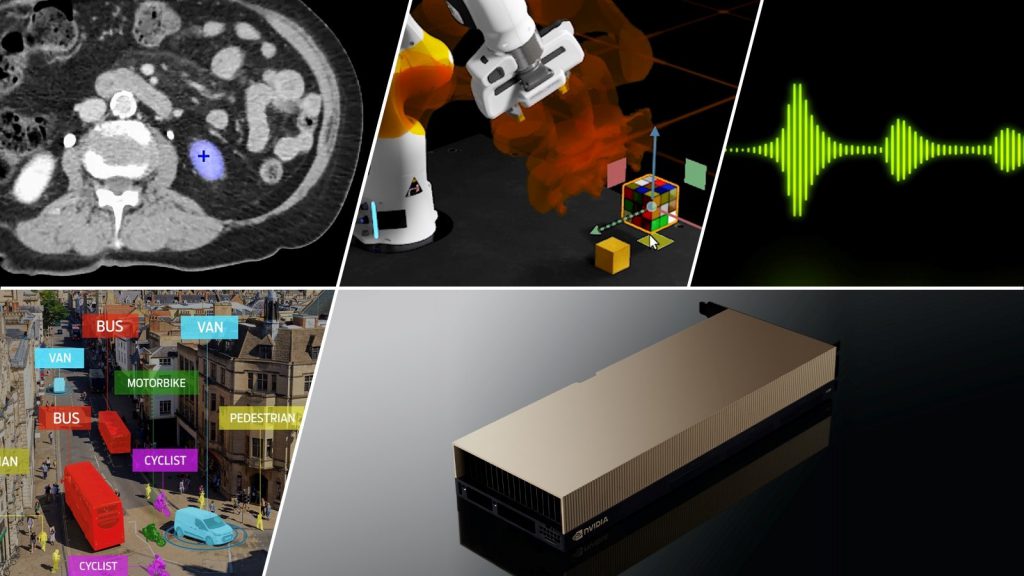

“Hopper là cỗ máy mới của các ‘nhà máy AI’, xử lý và tinh chỉnh hàng núi dữ liệu để đào tạo các mô hình với hàng nghìn tỷ tham số được sử dụng để thúc đẩy những tiến bộ trong AI dựa trên ngôn ngữ, người máy, chăm sóc sức khỏe và khoa học đời sống”, Jensen Huang, người sáng lập kiêm Giám đốc điều hành của NVIDIA, cho biết. “Hopper Transformer Engine tăng cường hiệu suất lên đến cấp độ vượt bậc, đưa AI và HPC quy mô lớn vào tầm với của các công ty và các nhà nghiên cứu.”

Ngoài kiến trúc Hopper và Transformer Engine, một số cải tiến quan trọng khác giúp GPU H100 mang lại bước nhảy vọt kế tiếp trong nền tảng trung tâm dữ liệu máy tính tăng tốc của NVIDIA, bao gồm GPU Multi-Instance thế hệ thứ hai, confidential computing, NVIDIA NVLink và DPX Instructions thế hệ thứ tư.

Một license 05 năm cho bộ phần mềm NVIDIA AI Enterprise hiện được kèm theo cho các máy chủ chính thống có GPU H100. Điều này tối ưu cho việc phát triển và triển khai các quy trình làm việc của AI và đảm bảo các tổ chức có thể truy cập vào các framework và công cụ AI cần thiết để xây dựng các chatbot AI, công cụ đề xuất, vision AI và nhiều hơn nữa.

Kế hoạch cung cấp toàn cầu của Hopper

H100 cho phép các công ty cắt giảm chi phí triển khai AI, mang lại hiệu suất AI tương đương với hiệu quả năng lượng cao hơn 3,5 lần và tổng chi phí sở hữu thấp hơn 3 lần, trong khi sử dụng ít hơn 5 lần số lượng node máy chủ so với thế hệ trước.

Đối với những khách hàng muốn ngay lập tức dùng thử công nghệ mới, NVIDIA cho biết H100 trên máy chủ Dell PowerEdge hiện đã có sẵn trên NVIDIA LaunchPad, nơi cung cấp các lab thực hành miễn phí, cho phép các công ty truy cập vào phần cứng và phần mềm NVIDIA AI mới nhất.

Khách hàng cũng có thể bắt đầu đặt hàng hệ thống NVIDIA DGX H100, bao gồm 8x GPU H100 và mang lại hiệu suất 32 petaflops ở độ chính xác FP8. Phần mềm NVIDIA Base Command và NVIDIA AI Enterprise cung cấp sức mạnh cho mọi hệ thống DGX, cho phép triển khai từ một node duy nhất cho đến cụm NVIDIA DGX SuperPOD hỗ trợ phát triển AI nâng cao của các mô hình ngôn ngữ lớn và khối lượng công việc lớn khác.

Các hệ thống hỗ trợ H100 từ các nhà sản xuất máy tính hàng đầu thế giới dự kiến sẽ xuất xưởng trong những tuần tới, với hơn 50 mẫu máy chủ trên thị trường vào cuối năm và hàng chục mẫu nữa vào nửa đầu năm 2023. Các đối tác xây dựng hệ thống bao gồm Atos, Cisco, Dell Technologies, Fujitsu, GIGABYTE, Hewlett Packard Enterprise, Lenovo và Supermicro.

Ngoài ra, một số cơ sở giáo dục đại học và nghiên cứu hàng đầu thế giới sẽ sử dụng H100 để cung cấp sức mạnh cho các siêu máy tính thế hệ tiếp theo của họ. Trong số đó có Trung tâm Siêu máy tính Barcelona, Phòng thí nghiệm Quốc gia Los Alamos, Trung tâm Siêu máy tính Quốc gia Thụy Sĩ (CSCS), Trung tâm Máy tính Tiên tiến Texas và Đại học Tsukuba.

H100 đến với Cloud

Amazon Web Services, Google Cloud, Microsoft Azure và Oracle Cloud Infrastructure sẽ là một trong những công ty đầu tiên triển khai các instance hỗ trợ H100 trên đám mây bắt đầu từ năm tới.

Nidhi Chappell, tổng giám đốc Azure AI Infrastructure cho biết: “Chúng tôi mong muốn tạo ra thế hệ tiếp theo của các mô hình AI trên GPU H100 mới nhất trong Microsoft Azure. “Với những tiến bộ trong kiến trúc Hopper cùng với các khoản đầu tư của chúng tôi vào siêu máy tính Azure AI, chúng tôi sẽ có thể giúp đẩy nhanh sự phát triển của AI trên toàn thế giới”

Karan Batta, phó chủ tịch quản lý sản phẩm của Oracle Cloud Infrastructure, cho biết: “Bằng cách cung cấp cho khách hàng của chúng tôi GPU H100 mới nhất từ NVIDIA, chúng tôi đang giúp họ tăng tốc quá trình học máy và workload HPC phức tạp nhất của họ. Ngoài ra, việc sử dụng thế hệ GPU H100 tiếp theo của NVIDIA cho phép chúng tôi hỗ trợ các workload lớn trong nội bộ của chúng tôi và giúp các khách hàng chung của chúng tôi có được những đột phá trong lĩnh vực chăm sóc sức khỏe, xe tự hành, robot và IoT.”

NVIDIA Software Support

Công nghệ Transformer Engine tiên tiến của H100 cho phép các doanh nghiệp phát triển nhanh chóng các mô hình ngôn ngữ lớn với mức độ chính xác cao hơn. Khi các mô hình này tiếp tục phát triển về quy mô, thì độ phức tạp cũng tăng theo, đôi khi cần phải đào tạo hàng tháng trời.

Để giải quyết vấn đề này, một số mô hình ngôn ngữ lớn và framework học sâu hàng đầu thế giới đang được tối ưu hóa trên H100, bao gồm NVIDIA NeMo Megatron, Microsoft DeepSpeed, Google JAX, PyTorch, TensorFlow và XLA. Các framework này kết hợp với kiến trúc Hopper sẽ tăng tốc đáng kể hiệu suất của AI để giúp đào tạo các mô hình ngôn ngữ lớn trong vòng vài ngày hoặc vài giờ.