Sự khác biệt giữa Card Ethernet và Bộ điều hợp InfiniBand là gì?

NIC là Network Interface Controller hay còn gọi là bộ điều hợp mạng hoặc card giao diện mạng, được sử dụng trên máy tính và máy chủ. Nó có thể giao tiếp với các switch, thiết bị lưu trữ, máy chủ và máy trạm thông qua cáp kết nối mạng (cáp đôi xoắn, cáp quang, v.v.). Với sự phổ biến ngày càng tăng của thị trường và khả năng kỹ thuật, cũng có nhiều loại card mạng khác nhau, chẳng hạn như thẻ Ethernet và thẻ InfiniBand. Bài viết này cũng tập trung vào sự khác biệt giữa card Ethernet và adapter InfiniBand, hy vọng sẽ giúp bạn chọn được card mạng phù hợp nhất.

Card Ethernet là gì?

Card Ethernet là một bộ điều hợp mạng được cắm vào khe cắm của bo mạch chủ và hỗ trợ chuẩn giao thức Ethernet. Mỗi bộ điều hợp mạng có một địa chỉ vật lý duy nhất trên toàn cầu, được gọi là địa chỉ MAC. Dữ liệu có thể được gửi chính xác đến máy tính đích dựa trên địa chỉ MAC của bộ điều hợp mạng. Có nhiều loại card Ethernet và nhiều phương pháp phân loại khác nhau. Chúng có thể được chia theo băng thông, giao diện mạng và giao diện bus. Thẻ Ethernet giao diện quang được gọi là thẻ Ethernet cáp quang (Bộ chuyển đổi Fiber-Ethernet). Nó tuân theo giao thức truyền thông Ethernet sợi quang và thường được kết nối với bộ chuyển mạch Ethernet sợi quang thông qua cáp quang. Đây là loại card mạng được sử dụng rộng rãi nhất. Hiện tại, bộ điều hợp Fiber-Ethernet có thể được phân loại theo giao diện bus và băng thông.

Phân loại giao diện xe buýt

Các loại giao diện bus card Ethernet có thể được phân loại thành PCI, PCI-Express (viết tắt là PCI-E), USB và ISA. ISA/PCI là giao diện bus sớm hơn và đang dần bị loại bỏ khi công nghệ trở nên hoàn thiện hơn. PCIe hiện là giao diện bus được sử dụng nhiều nhất và rất phổ biến trong các ứng dụng cấp công nghiệp và máy chủ.

1. Card PCIe hoạt động như thế nào?

PCIe là một phần đính kèm nối tiếp hoạt động giống như một mạng hơn là một bus. Sự khác biệt rõ ràng nhất so với các giao diện bus khác xử lý dữ liệu từ các nguồn khác nhau là PCIe kiểm soát luồng dữ liệu thông qua một công tắc để kết nối điểm-điểm. Thẻ PCle đưa vào khe và tạo ra kết nối logic (kết nối hoặc liên kết) để giao tiếp với nhau. Nó thường hỗ trợ các kênh liên lạc điểm-điểm giữa hai cổng PCle và có thể thực hiện các hành động gửi và nhận các yêu cầu hoặc ngắt PCI thông thường.

2. Card PCIe có những loại nào?

Thông số kỹ thuật: Thông thường số lượng kênh trong khe PCle xác định thông số kỹ thuật cho thẻ PCle. Các thẻ PCle thông thường có các thông số vật lý sau: x1, x4, x8, x16 và x32. Ví dụ: thẻ PClex8 có nghĩa là thẻ có tám kênh.

Phiên bản: PCIe thay thế các chuẩn bus PCI và PCI-X cũ và được sửa đổi liên tục để đáp ứng nhu cầu ngày càng tăng về băng thông cao. Phiên bản PCIe 1.0 (2.5GT/s) sớm nhất được ra mắt vào năm 2002, Sau này là PCIe 2.0 (5GT/s), PCIe 3.0 (8GT/s), PCIe 4.0 (16GT/s), PCIe 5.0 (32GT/s), PCIe 6.0 (64GT/s) và PCIe7.0 (128GT/s) đã xuất hiện. Tất cả các phiên bản PCIe đều hỗ trợ khả năng tương thích ngược.

Phân loại B và chiều rộng

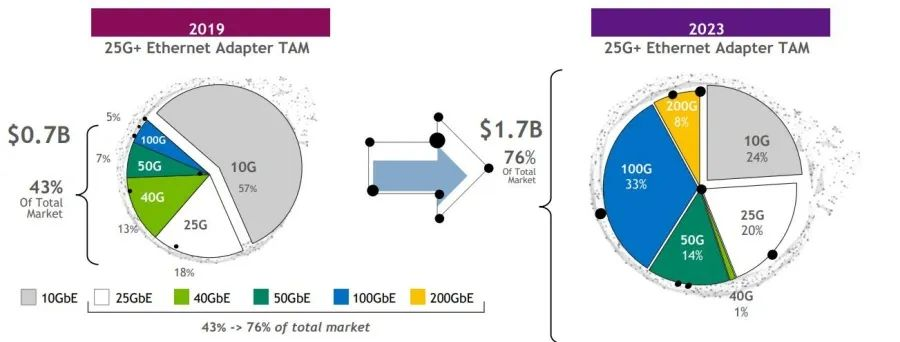

Khi lưu lượng truy cập Internet tăng lên từng ngày, thiết bị mạng chịu áp lực từ các ISP lớn trong việc liên tục lặp lại và cập nhật với yêu cầu hiệu suất cao hơn để đạt được tốc độ truyền dữ liệu 10G, 25G, 40G hoặc lên tới 100G. Một số thông tin cơ bản về chúng sẽ được trình bày chi tiết trong các phần sau.

1. Bộ điều hợp cáp quang 10G ( Bộ điều hợp máy chủ Ethernet )

Bộ điều hợp mạng cáp quang 10G sử dụng thẻ giao diện mạng bus PCI 32/64-bit, hỗ trợ cáp quang đơn chế độ hoặc đa chế độ 10G và phù hợp cho việc xây dựng mạng đường trục của doanh nghiệp và trường học. Đồng thời, Ethernet 10G có thể truyền lên tới 100 km, có thể đáp ứng yêu cầu truyền dẫn trong khu vực đô thị. Việc triển khai mạng 10G ở lớp xương sống của MAN có thể đơn giản hóa đáng kể cấu trúc mạng, giảm chi phí và tạo điều kiện bảo trì. Ethernet đầu cuối được sử dụng để xây dựng một MAN có chi phí thấp, hiệu suất cao và khả năng hỗ trợ dịch vụ phong phú.

2. Bộ chuyển đổi cáp quang 25G

Bộ điều hợp cáp quang 25G bù đắp cho băng thông thấp của Ethernet 10G và chi phí cao của Ethernet 40G bằng cách sử dụng công nghệ lớp vật lý kênh đơn 25Gb/s để đạt được tốc độ truyền 100G dựa trên bốn kênh cáp quang 25Gbps. Vì gói SFP28 dựa trên gói SFP+ và cả hai đều có cùng kích thước nên cổng bộ chuyển đổi sợi 25G có thể hỗ trợ tốc độ 25G cũng như 10G. So với bộ điều hợp mạng 10G, băng thông lớn hơn của NIC cáp quang 25G để đáp ứng nhu cầu mạng của các cụm máy tính hiệu năng cao, trong các bản nâng cấp mạng tốc độ 100G hoặc thậm chí cao hơn, bộ điều hợp cáp quang 25G sẽ là một trong những cơ sở hạ tầng không thể thiếu.

3. Bộ chuyển đổi cáp quang 40G

Bộ chuyển đổi cáp quang 40G có giao diện 40G QSFP+ hỗ trợ băng thông truyền 40Gbps. Máy còn hỗ trợ khe cắm chuẩn PCI-e x8 đảm bảo hoạt động hiệu quả và ổn định. Thường có sẵn ở các cổng đơn và cổng kép, NIC cáp quang 40G là giải pháp kết nối hiệu suất cao nhất cho các trung tâm dữ liệu doanh nghiệp, điện toán đám mây, điện toán hiệu năng cao và môi trường nhúng.

4. 100GBộ chuyển đổi sợi quang

Hiện nay, các bộ điều hợp mạng cáp quang 100G phổ biến nhất trên thị trường là cổng đơn và cổng kép. Mỗi cổng có thể cung cấp Ethernet lên tới 100 Gbit/s, đảm bảo định tuyến thích ứng cho đường truyền đáng tin cậy và nâng cao khả năng dỡ tải của vSwitch/vRouter. Card mạng 100G Fiber cung cấp giải pháp linh hoạt và hiệu suất cao, cung cấp một loạt các biện pháp giảm tải và tăng tốc cải tiến trong phần cứng để cải thiện hiệu quả của mạng trung tâm dữ liệu và kết nối lưu trữ.

Kết nối giữa máy chủ và switch ngày càng tăng lên với băng thông cao hơn. Thẻ Ethernet 25G đã trở thành thiết bị chủ đạo làm thiết bị trung gian giữa máy chủ 25G và bộ chuyển mạch 100G. Và khi trung tâm dữ liệu đang phát triển lên 400G với tốc độ chưa từng có, kết nối giữa máy chủ và switch sẽ tăng lên 100G, card mạng 100G cũng đóng vai trò không thể thiếu trong trung tâm dữ liệu.

Bộ chuyển đổi InfiniBand là gì ?

Mạng InfiniBand

Là một tiêu chuẩn giao tiếp mạng máy tính, InfiniBand được sử dụng rộng rãi trong điện toán hiệu năng cao (HPC) nhờ ưu điểm về băng thông thông lượng cao và độ trễ truyền mạng cực thấp. Mạng InfiniBand có thể được mở rộng theo chiều ngang thông qua các mạng chuyển mạch để thích ứng với các yêu cầu kết nối mạng ở nhiều quy mô khác nhau. Tính đến năm 2014, hầu hết các siêu máy tính TOP500 đều sử dụng công nghệ mạng InfiniBand. Trong những năm gần đây, các ứng dụng liên quan đến AI/dữ liệu lớn cũng đã áp dụng mạng InfiniBand để đạt được việc triển khai cụm hiệu suất cao.

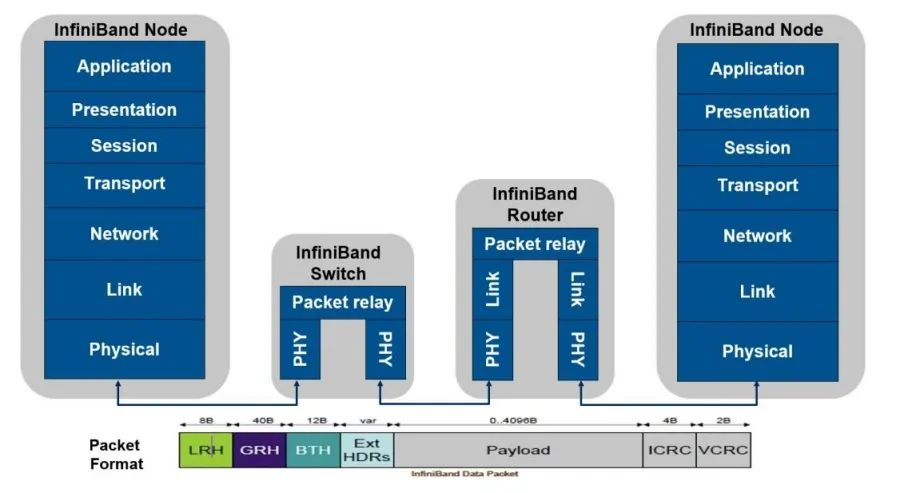

Là một giao thức phân lớp, InfiniBand xác định một ngăn xếp giao thức phân lớp tương tự như mô hình giao thức bảy lớp OSI. Bộ chuyển mạch IB tạo kênh trực tiếp riêng tư và được bảo vệ trên nút máy chủ. Trong kênh này, việc truyền dữ liệu và tin nhắn sẽ không còn yêu cầu xử lý CPU mà sẽ được thực hiện trực tiếp thông qua RDMA. Bằng cách này, các chức năng nhận và gửi sẽ được chuyển sang bộ điều hợp InfiniBand để xử lý. Về mặt vật lý, bộ điều hợp InfiniBand kết nối với bộ nhớ CPU dựa trên giao diện PCIe, cung cấp băng thông cao hơn, độ trễ thấp hơn và khả năng mở rộng lớn hơn các giao thức truyền thông khác.

Bộ chuyển đổi InfiniBand

Kiến trúc InfiniBand xác định một tập hợp các thành phần phần cứng cần thiết để triển khai kiến trúc và card mạng InfiniBand là một trong số đó. Bộ điều hợp InfiniBand còn được gọi là HCA – Bộ điều hợp kênh máy chủ. HCA là điểm mà tại đó nút cuối InfiniBand (chẳng hạn như máy chủ hoặc thiết bị lưu trữ) kết nối với mạng InfiniBand. Các kiến trúc sư của InfiniBand đã dành rất nhiều thời gian để đảm bảo rằng kiến trúc có thể triển khai nhiều hơn một chức năng HCA cụ thể cần có trong một phần cứng, chương trình cơ sở hoặc phần mềm duy nhất để tập hợp phần cứng, phần mềm và chương trình cơ sở cuối cùng đại diện cho chức năng HCA cung cấp quyền truy cập tới tài nguyên mạng cho một ứng dụng. Trên thực tế, cấu trúc hàng đợi được ứng dụng sử dụng để truy cập phần cứng InfiniBand sẽ xuất hiện trực tiếp trong địa chỉ ảo của ứng dụng. Cơ chế dịch địa chỉ tương tự là phương tiện để HCA truy cập bộ nhớ thay mặt cho các ứng dụng cấp người dùng. Thông thường các ứng dụng đề cập đến địa chỉ ảo; HCA có khả năng chuyển đổi các địa chỉ này thành địa chỉ vật lý để truyền thông tin.

Ưu điểm của Bộ chuyển đổi InfiniBand

- Card mạng InfiniBand cung cấp giải pháp kết nối có hiệu suất cao nhất và có khả năng mở rộng nhất cho máy chủ và hệ thống lưu trữ. Đặc biệt trong HPC, Web 2.0, điện toán đám mây, dữ liệu lớn, dịch vụ tài chính, trung tâm dữ liệu ảo hóa và ứng dụng lưu trữ sẽ có những cải thiện hiệu suất đáng kể, dẫn đến thời gian hoàn thành ngắn hơn và chi phí quy trình tổng thể thấp hơn.

- Bộ điều hợp InfiniBand là giải pháp lý tưởng cho các cụm HPC yêu cầu băng thông cao, tốc độ tin nhắn cao và độ trễ thấp để đạt được hiệu suất máy chủ và năng suất ứng dụng cao.

- Thẻ InfiniBand giảm tải xử lý giao thức và di chuyển dữ liệu của CPU từ CPU sang kết nối, tối đa hóa hiệu quả của CPU và thực hiện xử lý cực nhanh mô phỏng độ phân giải cao, tập dữ liệu lớn và thuật toán song song cao.

Cách chọn card mạng InfiniBand

- Băng thông mạng: 100G, 200G, 400G

- Số lượng bộ điều hợp trong một máy

- Tốc độ cổng: 100Gb/s (HDR100/EDR), 200Gb/s (HDR)

- Số cổng: 1/2

- Loại giao diện máy chủ: PCIe3/4 x8/x16, OCP2.0/3.0

- Cần có chức năng Socket-Direct hay Multi-host

InfiniBand so với Ethernet

- Băng thông : Vì hai ứng dụng này khác nhau nên yêu cầu về băng thông cũng khác nhau. Ethernet giống như một kết nối thiết bị đầu cuối hơn, không có nhu cầu cao về băng thông. InfiniBand được sử dụng để kết nối các máy chủ trong điện toán hiệu năng cao. Nó không chỉ tính đến khả năng kết nối mà còn tính đến cách giảm tải CPU trong quá trình truyền mạng tốc độ cao. Hưởng lợi từ công nghệ RDMA, mạng InfiniBand có thể đạt được khả năng tải CPU khi truyền tốc độ cao và cải thiện việc sử dụng mạng. Do đó, tốc độ CPU tăng mạnh sẽ không hy sinh nhiều tài nguyên hơn cho việc xử lý mạng và làm chậm quá trình phát triển hiệu suất HPC.

- Độ trễ : Chủ yếu được chia thành switch và network adapter để so sánh. Đối với bộ chuyển mạch: Là lớp công nghệ thứ hai trong mô hình truyền dẫn mạng, bộ chuyển mạch Ethernet có quy trình xử lý lâu dài, thường ở một số chúng tôi (hơn 200ns hỗ trợ cắt), trong khi bộ chuyển mạch InfiniBand có quy trình xử lý lớp 2 rất đơn giản. Công nghệ Cut-Through có thể rút ngắn đáng kể độ trễ chuyển tiếp xuống dưới 100ns, nhanh hơn nhiều so với bộ chuyển mạch Ethernet. Đối với bộ điều hợp mạng: Sử dụng công nghệ RDMA, card mạng InfiniBand có thể chuyển tiếp các gói mà không cần thông qua CPU, giúp tăng tốc đáng kể độ trễ đóng gói và giải mã gói (thường độ trễ nhận và gửi là 600ns). Tuy nhiên, độ trễ truyền và gửi của các ứng dụng TCP và UDP dựa trên Ethernet là khoảng 10us, chênh lệch hơn mười lần.

- Độ tin cậy : Trong lĩnh vực điện toán hiệu năng cao, việc truyền lại mất gói có tác động lớn đến hiệu suất tổng thể. Do đó, cần có một giao thức mạng có độ tin cậy cao để đảm bảo các đặc tính không bị mất dữ liệu của mạng từ cấp cơ chế, để đạt được các đặc tính có độ tin cậy cao. InfiniBand là một giao thức mạng hoàn chỉnh với các định dạng Lớp 1 đến Lớp 4 riêng. Các gói được gửi và nhận trên mạng dựa trên điều khiển luồng từ đầu đến cuối. Không có sự tích lũy bộ đệm khi truyền qua mạng InfiniBand, do đó độ trễ jitter được kiểm soát ở mức tối thiểu, do đó tạo ra một mạng thuần túy lý tưởng. Mạng được xây dựng bằng Ethernet không có cơ chế kiểm soát luồng lập kế hoạch, điều này không chỉ gây tốn kém mà còn tiêu thụ điện năng lớn hơn. Ngoài ra, do không có cơ chế kiểm soát luồng end-to-end nên mạng sẽ xuất hiện trong những trường hợp hơi cực đoan, dẫn đến tắc nghẽn bộ đệm và mất gói, khiến hiệu suất chuyển tiếp dữ liệu dao động rất lớn.

- Kết nối mạng : Mạng Ethernet yêu cầu mỗi máy chủ trong mạng gửi các gói định kỳ để đảm bảo cập nhật các mục nhập theo thời gian thực. Khi số lượng nút trong mạng tăng lên đến một mức nhất định, các cơn bão phát sóng sẽ được tạo ra, dẫn đến lãng phí nghiêm trọng băng thông mạng. Đồng thời, việc thiếu cơ chế học mục bảng của mạng Ethernet sẽ dẫn đến mạng lặp và Ethernet không có SDN đặc biệt, do đó định dạng gói hoặc cơ chế chuyển tiếp cần phải được thay đổi để đáp ứng các yêu cầu của SDN trong mạng triển khai, do đó làm tăng độ phức tạp của cấu hình mạng. InfiniBand ra đời với khái niệm SDN. Mỗi mạng InfiniBand lớp 2 có một trình quản lý mạng con để định cấu hình ID nút (LocalID) trong mạng. Sau đó, thông tin đường dẫn chuyển tiếp được tính toán thống nhất thông qua mặt phẳng điều khiển và được gửi đến bộ chuyển mạch InfiniBand. Bằng cách này, mạng InfiniBand Lớp 2 có thể được cấu hình mà không cần bất kỳ cấu hình nào, tránh tình trạng ngập lụt cũng như tránh được Vlan và ngắt mạng vòng. Do đó, một mạng Lớp 2 lớn với hàng chục nghìn máy chủ có thể được triển khai dễ dàng.

Khuyến nghị về card mạng

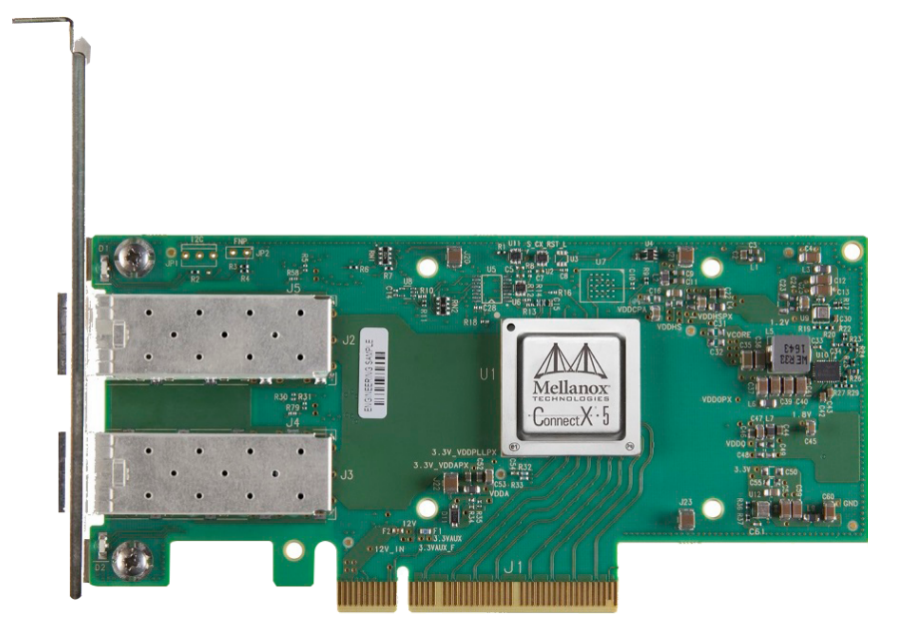

Card Ethernet ConnectX-5 (MCX512A-ACAT)

Thẻ giao diện Mạng Ethernet ConnectX-5 có tới hai cổng kết nối 10/25GbE, độ trễ 750ns, tốc độ lên tới 200 triệu gói mỗi giây (Mpps) và Bộ công cụ phát triển mặt phẳng dữ liệu (DPDK). Đối với khối lượng công việc lưu trữ, ConnectX-5 cung cấp một loạt khả năng tăng tốc cải tiến, chẳng hạn như chuyển đổi chữ ký trong phần cứng (T10-DIF), bộ chuyển mạch PCIe nhúng và giảm tải mục tiêu NVMe qua Fabric. Thẻ bộ điều hợp ConnectX-5 cũng mang đến khả năng giảm tải Open vSwitch tiên tiến cho các trung tâm dữ liệu viễn thông và đám mây để thúc đẩy tốc độ gói và thông lượng cực cao đồng thời giảm mức tiêu thụ tài nguyên CPU, từ đó tăng hiệu quả của cơ sở hạ tầng trung tâm dữ liệu.

Card Ethernet ConnectX-6 (MCX623106AN-CDAT)

ConnectX-6 Dx SmartNIC hỗ trợ tốc độ truyền 1/10/25/40/50/100GbE, các đường dẫn có thể lập trình linh hoạt cho các luồng mạng mới, đa homing với hỗ trợ tăng tốc mã hóa nội tuyến QoS, IPsec và TLS tiên tiến và tăng tốc mã hóa để chặn tĩnh dữ liệu. Đây là thẻ giao diện mạng đám mây tiên tiến và an toàn nhất trong ngành để tăng tốc các ứng dụng quan trọng của trung tâm dữ liệu như bảo mật, ảo hóa, SDN/NFV, dữ liệu lớn, máy học và lưu trữ.

Card mạng ConnectX-6 VPI IB (MCX653105A-ECAT-SP)

Thẻ ConnectX-6 VPI cung cấp một cổng duy nhất, độ trễ dưới 600ns và 215 triệu tin nhắn mỗi giây cho kết nối HDR100 EDR InfiniBand và 100GbE Ethernet. Hỗ trợ PCIe 3.0 và PCIe 4.0; các tính năng lưu trữ nâng cao, bao gồm mã hóa cấp khối và giảm tải tổng kiểm tra; cho giải pháp hiệu suất cao nhất và linh hoạt nhất được thiết kế nhằm đáp ứng nhu cầu ngày càng tăng của các ứng dụng trung tâm dữ liệu.

Card mạng ConnectX-5 VPI IB (MCX556A-ECAT)

Thẻ bộ điều hợp ConnectX-5 InfiniBand cung cấp giải pháp linh hoạt và hiệu suất cao với cổng kết nối InfiniBand và Ethernet hai cổng 100Gb/s, độ trễ thấp và tốc độ tin nhắn cao, cũng như các bộ chuyển mạch PCIe nhúng và NVMe qua Fabric, giảm tải. Các bộ điều hợp hỗ trợ Truy cập bộ nhớ trực tiếp từ xa (RDMA) thông minh này nhằm cung cấp khả năng giảm tải ứng dụng nâng cao cho Điện toán hiệu năng cao (HPC), siêu quy mô đám mây và nền tảng lưu trữ.

Từ các bộ điều hợp InfiniBand và thẻ Ethernet được đề cập ở trên, có thể dễ dàng nhận thấy chúng đều có những đặc điểm riêng và lĩnh vực ứng dụng tương ứng. Loại thẻ nào sẽ triển khai không chỉ phụ thuộc vào các giao thức được thẻ hỗ trợ mà còn phụ thuộc vào môi trường mạng và ngân sách của bạn.